1. 引言:驾驭数据流的时间维度

1.1 流处理的核心挑战

在无界数据流(Unbounded Data Streams)的世界中,数据永不停歇,事件纷至沓来。这种连续性带来了独特的挑战:单个数据点往往意义有限,其价值必须在特定的上下文中才能显现。而“时间”,正是赋予数据上下文和意义的关键维度。无论是统计一分钟内的交易额,还是分析用户半小时的会话行为,我们都必须在时间的长河中划定边界。然而,在分布式系统中,网络延迟、时钟不同步、节点故障等因素使得事件的顺序变得不可靠,形成了“乱序”和“迟到”这一流处理领域最核心的难题。

1.2 Flink 的精妙设计

Apache Flink 作为业界领先的流处理引擎,其卓越之处不仅在于高性能和高吞吐,更在于它为解决上述时间难题提供了一套精妙绝伦的解决方案。Flink 通过其先进的时间语义(Time Semantics)和灵活的窗口机制(Windowing),允许开发者精确地定义和控制数据处理的时间维度。这套体系能够优雅地处理事件乱序、数据延迟等复杂的现实问题,从而确保计算结果的准确性和确定性。

1.3 文章目标

本文旨在由浅入深,系统性地剖析 Flink 的时间与窗口核心概念、底层原理及实践方法。我们将从基础的时间语义辨析开始,逐步深入到水位线(Watermark)的生成与传递机制、窗口的实现原理,并最终通过代码实践和架构层面的探讨,帮助读者构建该领域的完整知识体系,从而能够自如地将这些强大的工具应用于实际项目中,真正驾驭数据流的时间维度。

2. 基础概念:构建 Flink 时间体系的基石

在深入 Flink 的内部机制之前,我们必须首先掌握构成其时间体系的几个核心概念。

2.1 三种时间语义的辨析

Flink 提供了三种截然不同的时间语义,以应对不同的业务需求和准确性要求。

- 事件时间 (Event Time): 事件在源头设备上实际发生的时间。这是保证结果准确性和可重现性的黄金标准,因为它反映了业务的真实发生顺序。

- 处理时间 (Processing Time): 数据在 Flink 算子中被处理时的机器本地时间。它的延迟最低,但结果受系统负载和网络状况影响,具有不确定性。

- 摄入时间 (Ingestion Time): 数据进入 Flink 数据源(Source)的时间。它是事件时间与处理时间的一种折衷,比处理时间稳定,但无法处理数据到达 Flink 之前的乱序。

[见下表:三种时间语义对比],该表从定义、时间来源、准确性、乱序处理能力、确定性和适用场景等多个维度,清晰地对比了这三者的核心差异。

| 特性 | 事件时间 (Event Time) | 处理时间 (Processing Time) | 摄入时间 (Ingestion Time) |

|---|---|---|---|

| 定义 | 事件在产生它的设备上实际发生的时间,通常作为数据的一部分。 | 数据到达 Flink 具体算子,并被该算子处理时的机器本地时间。 | 数据进入 Flink 数据流源头(Source)时的系统时间。 |

| 准确性 | 最高。真实反映了事件的业务发生顺序。 | 最低。与事件发生时间无关,受系统负载和网络延迟影响。 | 中等。是事件时间与处理时间的一种折衷方案。 |

| 乱序处理能力 | 强。通过 Watermark(水位线)机制,专为处理乱序和延迟数据设计,能保证计算结果的准确性。 | 无。数据按到达算子的顺序处理,无法处理乱序,先到先处理。 | 有限。只能处理进入 Flink 后的内部乱序,无法处理数据到达 Flink 前的乱序。 |

| 确定性 | 高。只要输入数据和处理逻辑不变,无论何时何地运行,结果都完全相同,可重现。 | 低。结果具有不确定性,每次运行都可能因环境变化而不同。 | 较高。通常情况下结果可重现,但依赖于数据源的读取顺序。 |

| 适用场景 | - 结果准确性要求极高的场景,如金融交易、计费、关键业务监控。<br>- 需要进行精确的用户行为分析、物联网(IoT)数据分析。 | - 延迟要求极低、准确性要求不高的场景,如实时监控告警。<br>- 对数据进行最快速的初步处理和观察。 | - 事件本身不带时间戳,但需要一个相对稳定、自动分配的时间戳。<br>- 对结果准确性有一定要求,但无法获取事件时间的折衷选择。 |

2.2 水位线 (Watermark) 简介

Watermark 是 Flink 事件时间处理的灵魂。

- 定义: Watermark 是一种特殊的、携带时间戳的系统消息,它像一个逻辑时钟一样,被 Flink 插入到数据流中,用于标记事件时间的进展。

- 核心作用: 一个时间戳为 T 的 Watermark (Watermark(T)) 的含义是:“在此时间点 T 之前的数据已经基本全部到达,系统可以处理 T 之前的窗口了”。它本质上是 Flink 在数据完整性(等待迟到数据)和处理延迟(尽快触发计算)之间做出权衡的机制,是触发事件时间窗口计算的核心信号。

2.3 四种核心窗口概述

窗口(Window)是将无限数据流切分成有限“桶”进行分析的机制。

- 滚动窗口 (Tumbling Window): 将数据流切分成固定大小、无重叠的连续窗口。适用于周期性报告,如每分钟的交易量。

- 滑动窗口 (Sliding Window): 窗口大小固定,但按指定的步长(Slide)向前滑动,因此窗口之间可以重叠。适用于移动平均计算,如计算最近10分钟的平均股价,每分钟更新一次。

- 会话窗口 (Session Window): 根据非活跃时间(Inactivity Gap)对数据进行分组。当数据到达的间隔超过指定的时间,前一个会话窗口关闭,新的会话窗口开启。窗口大小不固定,适用于分析用户行为会话。

- 全局窗口 (Global Window): 将所有拥有相同 Key 的数据分配到同一个、永不结束的全局窗口中。它必须配合自定义的触发器(Trigger)使用,否则窗口永远不会被触发计算。

3. 原理机制:深入 Flink 的时间心脏

理解了基础概念后,我们来探究其背后的实现原理,尤其是 Watermark 的运作机制以及 Flink 如何应对乱序数据。

3.1 水位线 (Watermark) 的生成与传递

- 生成策略: Flink 提供了两种主要的 Watermark 生成策略。

- 有序流策略 (forMonotonousTimestamps): 适用于时间戳单调递增的理想场景。Watermark 的时间戳就是当前收到的最大事件时间戳。

- 有界乱序策略 (forBoundedOutOfOrderness): 这是真实世界最常用的策略。它假设数据流的乱序程度是有限的,通过设置一个最大乱序延迟(maxOutOfOrderness)来生成 Watermark。其计算公式为:Watermark = 当前观察到的最大事件时间 - maxOutOfOrderness。这相当于给了乱序数据一段“等待时间”。

- 传递机制: Watermark 在 Flink 的算子任务间传递时遵循特定规则,以保证时间的一致性。

- 单流传递: 在单个数据流中,Watermark 从上游算子广播到所有下游算子实例。下游算子接收到后,更新自身的事件时钟。

- 多流合并 (Shuffle/Union): 当一个算子有多个输入流时(如 keyBy 或 union),它必须对齐所有输入流的事件时间。该算子会以所有上游并行实例中最小的 Watermark 作为自身的事件时钟。这被称为“木桶效应”,确保了在处理数据前,所有输入分区都已经达到了该时间点,从而保证了数据的完整性。

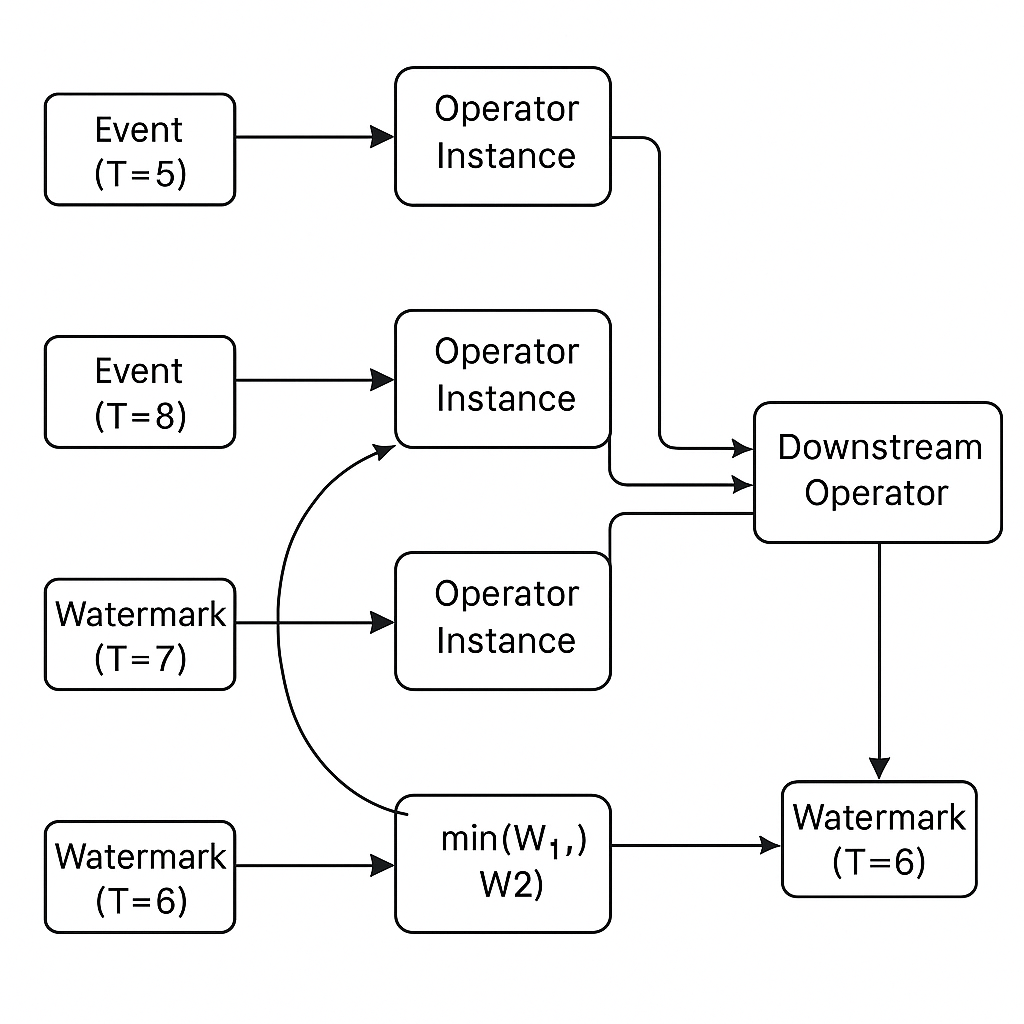

[图:水位线传递机制] 描绘了这一过程。图中,一个下游算子接收来自多个上游实例的数据。即使某些实例的事件时间进展很快(如

Event(T=8)),但只要有一个实例的 Watermark 还停留在较早的时间(如 Watermark(T=6)),下游算子的事件时钟就会被这个最慢的 Watermark 牵制,确保不会过早地处理数据,从而丢失可能在慢速流中迟到的数据。

3.2 窗口的实现与触发机制

- 底层实现对比:

- 滚动/滑动窗口: Flink 为每个元素根据其时间戳分配一个或多个窗口。实现相对简单,窗口的起始和结束时间是固定的。

- 会话窗口: 实现更为复杂。当一个新元素到达时,如果它无法被合并到任何现有窗口(即它与任何窗口的最后一条记录的时间差都大于 session gap),则会创建一个新窗口。如果它可以合并,则会将两个窗口的状态进行合并(Merging),形成一个更大的会话窗口。

- 核心触发条件: 对于事件时间窗口,其计算的主要触发条件是 Watermark 越过窗口的结束时间点(window_end_time <= watermark)。当 Flink 算子内部的事件时钟(由 Watermark 驱动)前进到超过某个窗口的结束边界时,系统就认为这个窗口的数据已经收集完毕,可以触发计算了。

[见下表:不同窗口类型特性对比] 总结了主流窗口类型的核心特性,以帮助进行技术选型。

| 窗口类型 | 定义 | 重叠性 | 适用场景 | API 示例 |

|---|---|---|---|---|

| 滚动窗口 <br/>(Tumbling Window) | 将数据流切分成固定大小、无重叠的连续窗口。每个元素只属于一个窗口。 | 否 | - 周期性报告:如每分钟的交易量、每小时的网站访问量 (PV/UV)。<br>- 按固定的时间间隔进行聚合统计。 | TumblingEventTimeWindows.of(Time.minutes(5)) |

| 滑动窗口 <br/>(Sliding Window) | 窗口大小固定,但按指定的步长(Slide)向前滑动,因此窗口之间可以重叠。 | 是 (当滑动步长小于窗口大小时) | - 移动平均计算:如计算最近10分钟的平均股价,每分钟更新一次。<br>- 需要平滑数据、观察趋势变化的场景。 | SlidingEventTimeWindows.of(Time.minutes(10), Time.minutes(1)) |

| 会话窗口 <br/>(Session Window) | 根据非活跃时间(Inactivity Gap)对数据进行分组。当数据到达的间隔超过指定的时间,前一个会话窗口关闭,新的会话窗口开启。窗口大小不固定。 | 否 | - 用户行为分析:如分析用户一次网站访问会话中的所有点击行为。<br>- 在线设备状态监控,根据心跳间隔判断设备是否离线。 | EventTimeSessionWindows.withGap(Time.minutes(30)) |

| 全局窗口 <br/>(Global Window) | 将所有拥有相同 Key 的数据分配到同一个、永不结束的全局窗口中。 | 不适用 | - 需要自定义复杂的窗口逻辑:必须配合自定义的触发器( Trigger )使用,否则窗口永远不会被触发计算。<br>- 对整个流或某个 Key 的所有数据进行聚合。 | GlobalWindows.create() |

3.3 乱序与迟到数据的三重保障体系

Flink 为处理乱序和迟到数据提供了三层防御机制,确保了数据处理的正确性和完整性。

- 第一层:Watermark 的延迟。

通过 forBoundedOutOfOrderness 设置一个乱序容忍度,Watermark 的生成本身就为大部分“微乱序”的数据提供了缓冲时间,等待它们到达。这是处理乱序的第一道防线。 - 第二层:允许数据迟到 (Allowed Lateness)。

- 原理: 在 Watermark 触发窗口计算后,窗口的状态默认会被清除。但通过调用 allowedLateness() API,可以使窗口的状态再额外保留一段时间。

- 效果: 在此期间到达的、属于该窗口的迟到数据仍可被正确处理,并触发对窗口结果的更新。这为那些比 Watermark 延迟更严重的“一般迟到”数据提供了第二次机会。

- 第三层:侧输出流 (Side Output)。

- 原理: 作为最终的“兜底”机制,通过 sideOutputLateData() API 可以捕获那些连 allowedLateness 也错过的“极度迟到”数据。

- 效果: 这些数据不会被丢弃,而是被放入一个独立的侧输出流中。这样可以避免关键数据丢失,允许开发者进行离线修复、手动回填或单独的告警分析。

4. 实践与案例:将理论付诸代码

理论的价值在于指导实践。本节将通过 DataStream API 代码展示如何应用上述概念。

4.1 DataStream API 核心代码示例

以下代码片段演示了如何配置一个完整的、包含 Watermark、窗口及迟到数据处理的 Flink 作业。

定义窗口与迟到数据处理:

// 定义一个用于存放极度迟到数据的 OutputTag

OutputTag<MyEvent> lateDataTag = new OutputTag<MyEvent>("late-data"){};

SingleOutputStreamOperator<Result> result = withTimestampsAndWatermarks

.keyBy(event -> event.getKey())

.window(TumblingEventTimeWindows.of(Time.seconds(10)))

.allowedLateness(Time.minutes(1)) // 允许1分钟的迟到

.sideOutputLateData(lateDataTag) // 将更迟的数据放入侧输出

.process(new MyProcessWindowFunction()); // 在窗口函数中执行业务逻辑

// 从主结果流中获取侧输出流,处理极度迟到的数据

DataStream<MyEvent> lateStream = result.getSideOutput(lateDataTag);

lateStream.print("Extremely late data");配置时间特性与 Watermark 生成:

从 Flink 1.12 版本开始,事件时间已成为默认的时间特性,无需显式设置。

// Flink 1.12+ 默认使用事件时间, 无需 env.setStreamTimeCharacteristic(...)

DataStream<MyEvent> stream = ...;

// 分配时间戳并定义 Watermark 策略

// 假设数据最多乱序 5 秒

DataStream<MyEvent> withTimestampsAndWatermarks = stream.assignTimestampsAndWatermarks(

WatermarkStrategy.<MyEvent>forBoundedOutOfOrderness(Duration.ofSeconds(5))

.withTimestampAssigner((event, timestamp) -> event.getTimestamp())

);4.2 综合案例:实时分析网站用户点击流

- 场景设定: 模拟一个电商网站,需要实时统计每1分钟更新一次的、最近5分钟内各类商品的点击热度。数据从 Kafka 消费,可能存在网络延迟导致的事件乱序。

- 实现步骤:

- 定义事件 POJO: 创建 ClickEvent 类,包含 userId、productId、timestamp 等字段。

- 数据源: 从 Kafka 主题读取 JSON 格式的点击事件,并反序列化为 ClickEvent 对象。

- Watermark 生成: 使用 forBoundedOutOfOrderness 策略分配时间戳和生成 Watermark,以处理乱序。例如,设置10秒的乱序容忍度。

- 分组: 按商品ID(productId)进行 keyBy 分组。

- 窗口应用: 应用一个大小为5分钟、滑动步长为1分钟的滑动事件时间窗口 (SlidingEventTimeWindows)。

- 聚合计算: 在窗口函数(如 ProcessWindowFunction)中,对窗口内的元素进行计数,并输出包含商品ID、窗口结束时间以及点击次数的结果。

- 迟到数据处理(可选): 配置 allowedLateness 和 sideOutputLateData 来展示完整的迟到数据处理流程,确保结果的最终正确性。

5. 架构/系统层面:Flink 的统一时空观

Flink 对时间精妙的处理方式,不仅解决了流处理的难题,更是其实现“流批一体”宏大愿景的理论基石。

5.1 流批一体的基石

从 Flink 的视角看,批处理是流处理的一个特例。一个批处理作业可以被看作是对一个“有界数据流”(Bounded Stream)的处理。在这个有界流的末尾,Flink 会发送一个时间戳为正无穷大的 Watermark,这个最终的 Watermark 会确保所有窗口都被触发和关闭,从而得到最终的、一致的结果。

正是基于事件时间和 Watermark 这套统一的时空模型,Flink 才能使用同一套 API 和引擎逻辑来处理历史数据(批)和实时数据(流)。

5.2 设计优势分析

- 一致性: 一套代码逻辑可以无缝地运行在历史数据回放和实时数据处理上,保证了业务分析口径的绝对一致。

- 正确性: 基于事件时间的设计,从根本上保证了业务逻辑的计算结果不受系统运行时环境的影响,确保了“正确性”。

- 灵活性: Flink 提供了从 Watermark 延迟、allowedLateness 到 sideOutput 的多层次 API,允许开发者在延迟、成本和数据完整性之间根据业务需求做出灵活的权衡。

6. 总结与展望

6.1 核心内容回顾

本文系统地剖析了 Flink 的时间与窗口机制。我们可以将其核心思想概括为四大支柱:

- 时间语义:提供了事件时间、处理时间、摄入时间三种选择,其中事件时间是保证正确性的基石。

- 水位线 (Watermark):作为事件时间的逻辑时钟,是解决乱序、驱动窗口计算的核心。

- 窗口机制:提供了滚动、滑动、会话等多种切分数据流的方式,以满足不同分析场景。

- 迟到数据处理:通过 Watermark 延迟、allowedLateness 和侧输出流构建了三层防御体系,最大限度地保证了数据完整性。

6.2 Flink 的关键优势

Flink 在时间处理方面的严谨设计,是其成为业界领先流处理框架的核心竞争力之一。它没有回避真实世界中数据不完美的现实,而是为开发者提供了一套完备且强大的工具集来正面应对这些挑战,使得构建正确、可靠、可维护的流处理应用成为可能。

6.3 发展趋势展望

展望未来,Flink 在时间处理领域仍有探索空间。例如,更智能化的 Watermark 自动生成与调优机制,以减少手动参数调整的复杂性;针对跨多个异构数据源的复杂场景,如何进行高效的时间对齐;以及在 SQL/Table API 中对时间窗口操作的进一步增强和简化,让更广泛的用户能够利用 Flink 强大的时间处理能力。这些都将是 Flink 社区持续演进的重要方向。